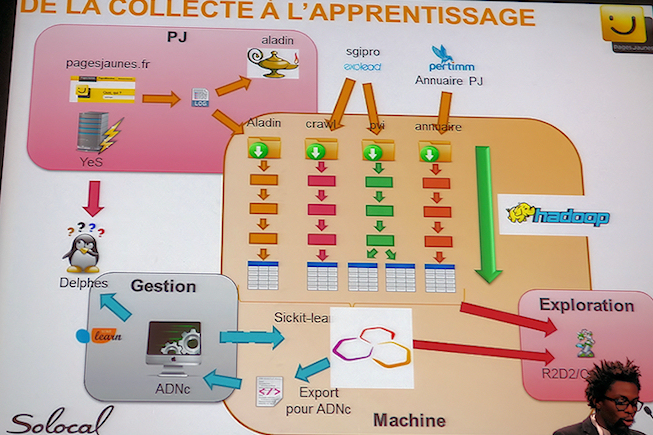

PagesJaunes améliore de 30% la productivité de ses équipes chargées d’optimiser son moteur de recherche via le Big Data et le Machine Learning. C’est ce qu’a présenté Guibert Tchindé, Data Scientist chez PagesJaunes, le 1 avril sur la scène du salon Big Data.

Une plateforme Hadoop

Les données issues des requêtes et des réponses du moteur de recherche sont toutes injectées dans une plateforme Open Source Hadoop. “Hadoop n’est pas cher” souligne Guibert Tchindé. De cette plateforme, on sort les requêtes qu’il est important que les équipes de PagesJaunes examinent de près afin d’améliorer le fonctionnement du moteur de recherche. Il s’agit de détecter les failles du moteur de recherche.

« On détecte quand une réponse n’est pas satisfaisante lorsque la liste de réponses est trop longue, cela signifie que le moteur n’a pas réussi » illustre Guibert Tchindé. « De même, lorsque quelqu’un ne clique pas dans la page, cela signifie qu’aucun choix n’a répondu aux attentes de l’internaute. » De même, les erreurs d’orthographe lors de la saisie par l’utilisateur sont traquées afin de proposer une correction à l’internaute et les résultats associés.

Les outils de mise en forme de Dataiku

La plateforme Hadoop déployée est complétée par des outils de mise en forme des données délivrés par la startup française Dataiku. Son outil Data Science Studio permet de rapidement formater les données. PagesJaunes a procédé à une modélisation algorithmique de la fragilité de la recherche utilisateur. Un système d’apprentissage intégré a été développé autour de Python et de R.

Photo, Guibert Tchindé, Data Scientist chez PagesJaunes.