L’IA doit évoluer vers une compréhension du monde physique, raisonner et planifier. C’est que cherche à faire Yann Lecun, Chief AI Scientist chez Meta afin que la machine puisse atteindre le niveau de l’intelligence humaine. Pour cela, il défend l’IA pilotée par objectif, « objective driven AI ». Il a pris la parole lors du salon Vivatech 2024, le 22 mai.

Progresser en s’inspirant d’idées anciennes

Yann Lecun décrit la manière dont on peut progresser vers cette IA pilotée par objectif en s’inspirant d’idées déjà anciennes, employées en intelligence artificielle et Machine Learning (Apprentissage Automatique) et par les grands modèles de langages LLMs (Large Language Models).

“Cela été une réussite étonnante dans le cas du langage”

Pour les LLMs, l’idée consiste à prendre un texte, on retire certains mots, et on entraine un gigantesque réseau de neurones pour prédire les mots qui manquent. Selon l’architecture du réseau de neurones, on peut ensuite utiliser ce réseau de neurones pour prédire le prochain mot dans un texte. On lui montre un mot et il prédit le prochain mot. On injecte alors ce mot qui a été prédit en entrée, et le réseau de neurones prédit le mot suivant, etc. « C’est comme cela que n’importe quel LLM fonctionne. Cela s’appelle un LLM auto régressif » résume Yann Lecun.

Les LLMs sont stupéfiants

Pour lui, il est stupéfiant de voir combien de connaissances ces systèmes peuvent apprendre de datas textes brutes en étant entrainés sur les textes publiés sur le web, typiquement de 10 à 20 trillions de tokens, un token étant une partie de mot.

“Nous comprenons le monde principalement en apprenant par l’observation“

L’idée évidente est alors d’utiliser la même idée que celle employée pour reconstituer un texte. « Prenez une vidéo, enlevez des parties de vidéo et entrainez un gigantesque réseau de neurones pour prédire la partie manquante » décrit-il. Si le système est capable de faire cela, il aura compris la nature du monde, que les objets bougent de manière indépendante, que la perspective change quand on bouge la caméra, plein de choses sur le monde comme les bébés.

Une percée dans la compréhension des vidéos

Mais cela n’a pas marché. « Cela ne marche pas. Nous avons essayé de le faire fonctionner pendant dix ans. C’est une vieille idée » dit-il. Mais il y a eu une percée sur les 4 à 5 dernières années. « C’est quand nous avons compris que la meilleure manière de faire cela n’est pas d’avoir le système qui reconstruit l’entrée, prédit ce qui va arriver dans une vidéo avec tous les détails, ce qui est l’idée dans un modèle génératif » présente-t-il.

“Le prédicteur est entrainé dans cet espace de représentation avec les représentations abstraites des vidéos“

Pour lui, on peut essayer de redécouvrir cette idée. « On essaye d’entrainer un système à comprendre le monde de cette manière. Vous faites en sorte que le système regarde un bout de vidéo, il en extrait une représentation, cela peut être l’idée que le système se fait de l’état du monde à un moment donné. Et on observe une action, que quelqu’un effectue, et vous entrainez le système à prédire l’état du monde après que l’on a fait cette action » poursuit-il.

Le système devient capable de planifier pour atteindre un objectif

Un système comme cela est un modèle du monde. Si vous pouvez prédire l’état du système au temps t+1, depuis l’état du monde au temps t et une action que vous pouvez prendre, « vous avez une manière de prédire les conséquences qu’une séquence d’actions peut avoir. Vous avez alors un système capable de planifier. Il peut déterminer par recherche quelle séquence d’actions mener pour parvenir à un but particulier ou un objectif, j’appelle cela ‘objective driven AI’» revendique-t-il. C’est-à-dire une IA pilotée par objectif.

“Cela peut être la future architecture d’un système d’IA qui peut être capable de raisonner et planifier”

Il reste beaucoup de détails à remplir. « C’est un concept. C’est quelque chose comme un plan sur 5 à 10 ans. Je pense que vous allez voir des effets sur des systèmes pratiques à plus court terme, peut être dans quelques années » conclut-il.

Top lectures en ce moment

-

Les personnages de Disney pourront être utilisés dans des vidéos créées par l...

-

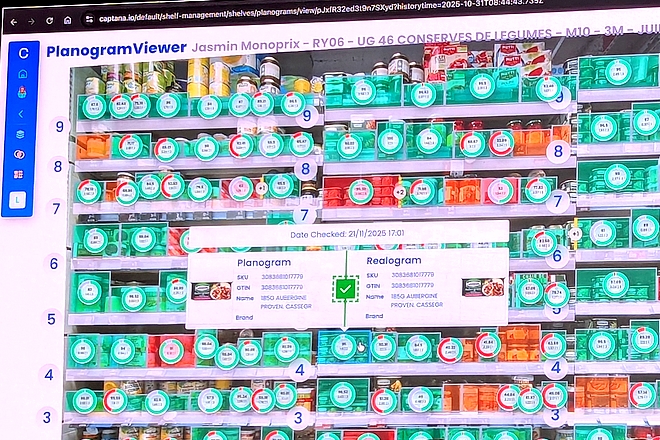

Livraison en 1 heure par Carrefour : une créa publicitaire réalisée avec une IA...

-

IA générative : pourquoi Carrefour privilégie l’approche Top-Down et garde lR...

L'IA clé de nos besoins vitaux dans l'eau, l'électricité et le gaz

Marchés de l’eau : l’IA générative arrive dans les réponses aux appels d’offres des collectivités

Saur, spécialiste de la distribution d’eau potable, fait évoluer son processus de réponse aux appels d’offres des collectivités et des industriels en y injectant de l’IA géné…

Stockage de l’électricité : l’IA générative outil d’accélération clé chez Engie

Le stockage de l’électricité est un enjeu stratégique. Engie s’y attelle et mobilise pour cela l’IA générative de type RAG, c'est-à-dire basée sur le traçage des documents source. …

Nouvelle donne dans le gaz naturel : GRDF s’adapte en utilisant l’IA

GRDF, leader de la distribution du gaz naturel en France, affine sa stratégie d’IA. Il s’appuie sur des serveurs internes pour la confidentialité des données de ses clients. GRDF c…

Et vous, qu’en pensez-vous ?

Une idée, une réaction, une question ? Laissez-nous un mot ci-dessous.

Je réagis à cet article