La prévision de la demande est une discipline clé pour le secteur de la grande distribution, surtout pour la vente des produits frais. Prosol avec son enseigne Grand Frais disposait d’algorithmes de prévision classiques. Il a revu sa copie avec des algorithmes de nouvelle génération pour une précision accrue de 10 % à 40 %. L’enjeu est alors que ces nouveaux outils soient adoptés par les équipes de terrain.

Connu pour ses enseignes Grand Frais, Fresh et la Boulangerie du Marché, Prosol est un acteur de la distribution spécialisé dans les produits frais. A cet égard, la prévision de la demande de la clientèle est cruciale, tant pour améliorer la trésorerie de l’enseigne par réduction des stocks, mais aussi en répondant aux besoins client, d’où leur satisfaction.

Réduire les ruptures de stocks et satisfaire les clients

Une prédiction fiable permet de réduire le nombre des ruptures de stocks et les clients trouvent toujours des produits frais dans les rayons. C’est aussi un enjeu clé pour la réduction du gaspillage alimentaire et contribue fortement à la rentabilité.

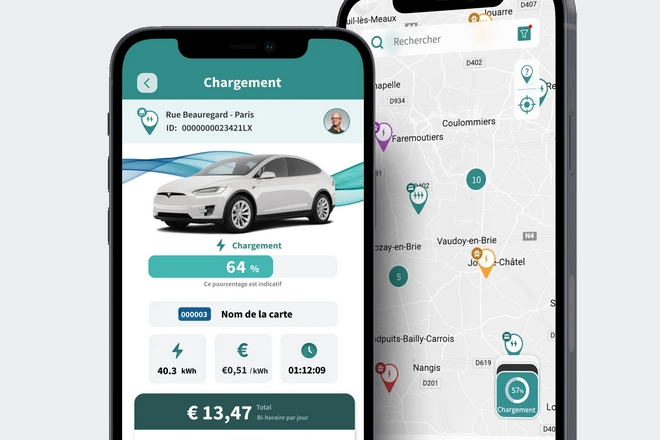

Le responsable de rayon décide des quantités à acheter à J +2, et il passe ses commandes tous les jours

Disposer d’une recommandation précise pour chaque produit et déjà renseignée dans l’outil de prise de commande va faire gagner énormément de temps au chef de rayon. Les Chefs de rayon doivent compléter toutes les lignes produit de leur rayon, soit de 400 à 500 références.

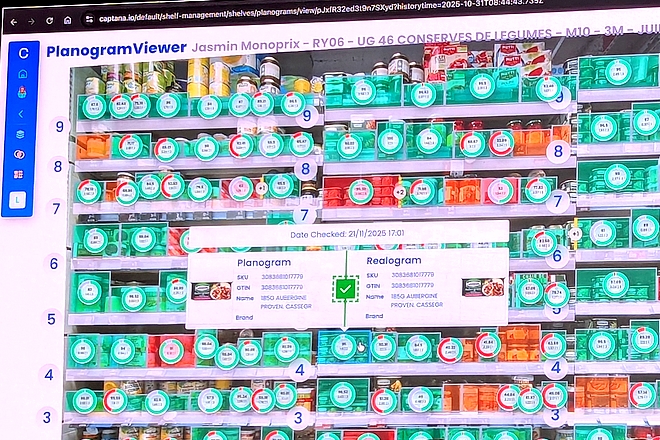

Les recommandations peuvent être acceptées ou modifiées

« Lors du passage des commandes, le responsable de rayon reçoit les recommandations du système d’IA. Il peut alors soit accepter cette prédiction, soit la modifier » présente Fanjuan Shi, Group CIO (Chief Information Officer) et CDO (Chief Data Officer) de Prosol. « Nous utilisons les algorithmes de Machine Learning pour prédire les volumes de vente pour chaque magasin et chaque produit » dit-il. « Cette information est combinée avec le niveau de stock restant et des règles de calcul pour définir les quantités à commander. »

La qualité des prévisions était jugée insuffisante pour 20 à 30 % des séries. D’où le recours aux algorithmes Prophet et XG Boost

La société de conseil Equabcy n’est bien évidemment pas partie d’une page blanche. Elle a pu s’appuyer sur toute l’infrastructure, les historiques de vente, les mouvements de stocks, les variations de prix ainsi que sur les données relatives aux produits afin de mettre en place les nouveaux algorithmes. « Avant d’arriver aux algorithmes, nous avons mis en place des transformations de données, calculé des moyennes mobiles et d’autres données destinées à améliorer l’efficacité des futurs algorithmes » explique Florian Laroumagne, directeur Data Science chez Equancy.

Deux modèles complémentaires à évaluer, Prophet et XGBoost

« Nous sommes passés d’algorithmes ‘historiques’ comme Arima, les dérivées et le lissage exponentiel, des méthodes statistiques qui fonctionnent, mais qui ne sont plus à l’état de l’art » poursuit-il. « On cherche à prédire correctement et nous avons proposé d’évaluer deux modèles complémentaires : Prophet qui est issu de Facebook et que nous avons challengé avec XGBoost. »

L’idée était de créer un gros modèle capable de prédire plusieurs quantités pour plusieurs produits et plusieurs magasins

Les résultats étaient très encourageants, y compris sur les promotions. Avant d’être utilisés en mode prédictif, les algorithmes ont été entraînés puis « back testés » c’est à dire testés sur les valeurs passées afin de vérifier leur précision. Cette précision a été mesurée avec l’indicateur RMSE (erreur quadratique moyenne).

Amélioration de la précision des prédictions avec XGBoost

Sur une prévision d’un produit permanent dans un magasin, avec l’algorithme de lissage exponentiel, Prosol obtenait une erreur RMSE moyenne de 11,7 pour ses prévisions à J-1. Avec XGBoost, l’écart est tombé à 9,5 en moyenne, soit une amélioration de 19% de la précision, mais sur la prévision à 14 jours. En outre, tous les jours peuvent être prédits, y compris les jours très atypiques dans la distribution, comme le 1er mai qui causent de gros problèmes aux algorithmes « classiques ».

Aucun algorithme ne peut prédire la quantité qui sera vendue le jour 1 d’une promotion

Avec le nouvel algorithme mis en place avec Equancy, l’algorithme ne prévoit pas le pic du jour 1, mais la remise à jour de la prédiction du lendemain permet à l’algorithme de se recadrer immédiatement. Au final, la baisse du niveau d’erreur atteint 25%.

Prédictions possibles lors de l’ouverture d’un nouveau magasin

« Nous avons aussi la capacité de délivrer des prédictions pour un nouveau magasin » indique Florian Laroumagne. « Grand Frais ouvre régulièrement de nouveaux points de vente et avec un historique de vente de 2 semaines seulement nous pouvons commencer à délivrer des prévisions de vente alors qu’il fallait attendre plusieurs mois avant de le faire avec les méthodes classiques. »

Des gains informatiques de n’avoir plus qu’un seul algorithme à déployer, à maintenir et à faire évoluer

Les gains opérationnels de cette nouvelle approche sont élevés. « L’amélioration de la prévision dans nos magasins a permis de réduire de 5% à 10% le taux de casse» présente Fanjuan Shi. Le taux de casse est la valeur des produits frais qui ont du être jetés divisée par la valeur totale des produits. « Cela représente une économie considérable, car chaque dixième de pourcent représente des millions d’euros » confie-t-il.

Prévoir la conduite du changement lors de la mise en place de l’outil

Pour le CIO, un autre point important porte sur la conduite du changement. Pour lui, un projet d’IA et de Data Science n’est pas qu’un projet technique. Il faut s’assurer de son adoption de son adéquation avec les besoins des utilisateurs métier. « Nous mesurons notamment le taux de modification des prévisions et quelle est l’ampleur des modifications qui sont apportées » dit-il.

“Cela nous permet d’évaluer si l’outil est effectivement une aide”

Enfin, le responsable se félicite de la réduction du nombre de modèles à gérer, un progrès majeur sur le plan FinOps. « Un projet d’IA et de Data Science n’est pas qu’un projet technique, mais il faut s’assurer que les gens utilisent l’outil » insiste-t-il.

Top lectures en ce moment

-

Livraison en 1 heure par Carrefour : une créa publicitaire réalisée avec une IA...

-

Les personnages de Disney pourront être utilisés dans des vidéos créées par l...

-

IA générative : pourquoi Carrefour privilégie l’approche Top-Down et garde lR...

L'IA clé de nos besoins vitaux dans l'eau, l'électricité et le gaz

Marchés de l’eau : l’IA générative arrive dans les réponses aux appels d’offres des collectivités

Saur, spécialiste de la distribution d’eau potable, fait évoluer son processus de réponse aux appels d’offres des collectivités et des industriels en y injectant de l’IA géné…

Stockage de l’électricité : l’IA générative outil d’accélération clé chez Engie

Le stockage de l’électricité est un enjeu stratégique. Engie s’y attelle et mobilise pour cela l’IA générative de type RAG, c'est-à-dire basée sur le traçage des documents source. …

Nouvelle donne dans le gaz naturel : GRDF s’adapte en utilisant l’IA

GRDF, leader de la distribution du gaz naturel en France, affine sa stratégie d’IA. Il s’appuie sur des serveurs internes pour la confidentialité des données de ses clients. GRDF c…

Et vous, qu’en pensez-vous ?

Une idée, une réaction, une question ? Laissez-nous un mot ci-dessous.

Je réagis à cet article