A l’heure du décollage de l’intelligence artificielle, les algorithmes se multiplient dans notre quotidien. Afin d’éviter que ces algorithmes ne prennent des décisions inéquitables, ils doivent faire l’objet d’un contrôle via des tests spécifiques. C’est ce que préconise l’Institut Montaigne.

Un texte de loi pourrait brider l’innovation

L’Institut privilégie cette voie plutôt qu’un texte de loi qui viendrait brider l’innovation sans forcément résoudre le problème des biais. « Définir ce qu’est un algorithme sans biais est complexe, Des biais inconscients peuvent conduire à discriminer certains groupes et d’autres biais peuvent être volontaires » rappelle l’Institut. Dans certains cas, des biais peuvent entraîner des discriminations. C’est-à-dire que l’algorithme aboutit de manière involontaire à des propositions différentes selon, entre autres, que la personne soit d’un sexe ou d’une origine ethnique spécifique.

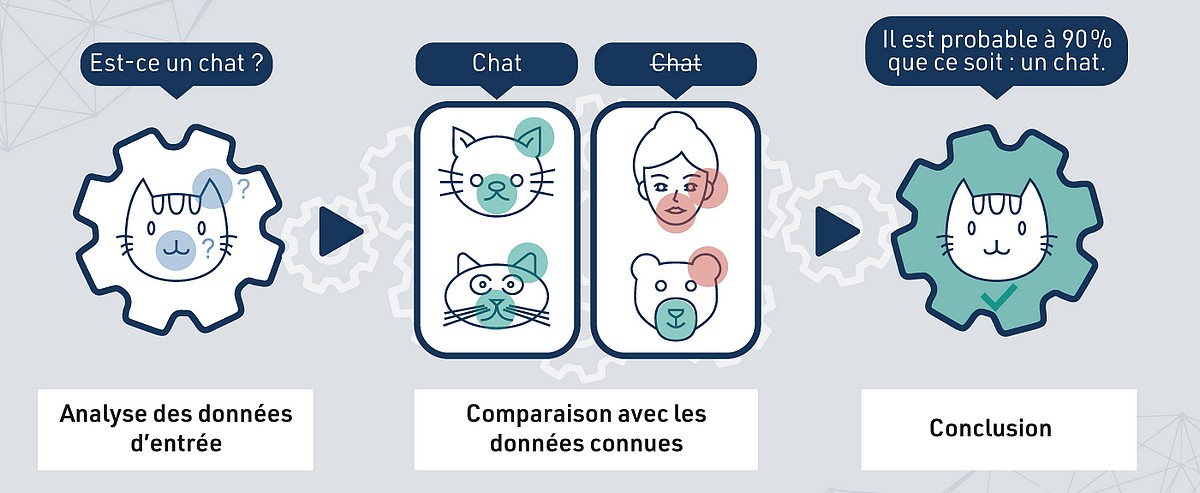

Il faut inclure les paramètres sensibles tels que le sexe, l’âge, l’ethnicité, la religion et vérifier l’indépendance du résultat

L’Institut considère que la position de la France n’est pas pertinente en matière d’algorithmes lorsqu’elle fait le choix de ne reconnaître que des citoyens, égaux en droits. La raison ? Un algorithme peut par exemple introduire des biais contre les femmes même si le sexe est exclu des variables utilisées. L’algorithme déduira cette information à partir d’autres paramètres comme le fait d’acheter des soins pour femme. De manière générale, même en l’absence de variables sensibles, elles peuvent être approchées par l’algorithme.

Un algorithme performant et équitable coûte cher

Il est plus complexe et plus coûteux de produire des algorithmes performants et équitables, estime l’Institut Montaigne. Il ne demande pas pour autant des lois spécifiques pour encadrer a priori la création d’un nouvel algorithme.

Il ne faut pas que la suspicion qu’un algorithme ait un biais amène à se priver de nouveaux outils

Pour les algorithmes plus importants, pouvant restreindre l’accès à des services essentiels comme un compte bancaire, la recherche d’un emploi, mettre en danger la sécurité, bafouer les droits fondamentaux, il faut de la transparence en ce qui concerne les données utilisées et les objectifs fixés à l’algorithme ainsi qu’un droit de recours contre la décision prise.

Des équipes qui doivent être diverses

Par ailleurs, l’Institut demande de la diversité sociale dans les équipes qui développent les algorithmes afin de lutter contre les biais. Cela concerne les profils, le sexe, l’expérience, l’âge et les compétences. Au-delà, il convient de former et sensibiliser les gens aux enjeux des biais, mettre en place une charte de bonnes pratiques au sein de l’entreprise et accorder de l’intérêt aux labels qui apportent une garantie en matière de qualité des données utilisées pour entraîner les algorithmes.

Des bases de données de test publiques doivent permettre aux entreprises d’évaluer les biais de leur méthodologie

Enfin, il faut rappeler qu’il existe de nombreux textes de lois centrés sur la lutte contre les discriminations et qu’ils s’appliquent aux algorithmes avant toute autre considération. Cette obligation existe déjà par exemple dans le domaine bancaire.

Une banque doit être transparente quand elle accorde un crédit

Les banques classiques sont soumises à des réglementations qui brident leur créativité. « Par exemple, pour réaliser du scoring dans le cas de l’octroi d’un prêt, nous n’avons pas le droit d’utiliser de l’intelligence artificielle » illustre Frédéric Burtz, directeur adjoint de la direction digital et data, directeur de la 89C3 Factory, responsable des usages avancés de la data et de l’IA pour le groupe bancaire BPCE (Banque Populaire Caisse d’Epargne).

« Il faut que l’on puisse expliquer pourquoi un prêt a été octroyé ou pas. Si c’est un réseau de neurones [NDLR : technologie d’apprentissage automatique en intelligence artificielle] qui a été entraîné, nous ne savons pas expliquer. Notre autorité de supervision ne reconnaît pas ces moyens là comme étant satisfaisants pour faire de l’octroi » conclut-il.

Retrouver l’étude de l’Institut Montaigne ICI.

Top lectures en ce moment

-

Les personnages de Disney pourront être utilisés dans des vidéos créées par l...

-

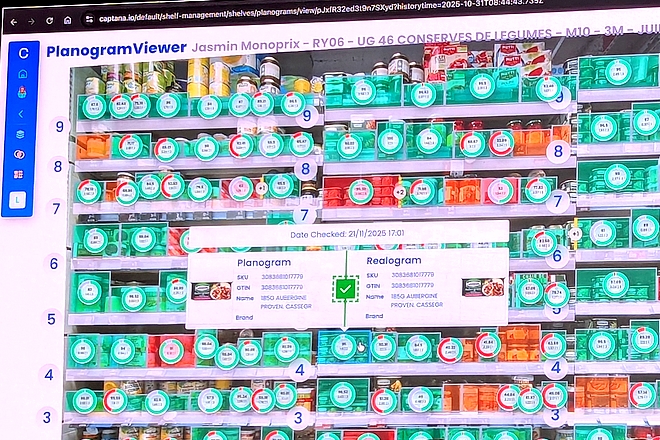

Livraison en 1 heure par Carrefour : une créa publicitaire réalisée avec une IA...

-

Le géant Veolia crée l’entreprise agentique de 2025 en direct avec ses employés

L'IA clé de nos besoins vitaux dans l'eau, l'électricité et le gaz

Marchés de l’eau : l’IA générative arrive dans les réponses aux appels d’offres des collectivités

Saur, spécialiste de la distribution d’eau potable, fait évoluer son processus de réponse aux appels d’offres des collectivités et des industriels en y injectant de l’IA géné…

Stockage de l’électricité : l’IA générative outil d’accélération clé chez Engie

Le stockage de l’électricité est un enjeu stratégique. Engie s’y attelle et mobilise pour cela l’IA générative de type RAG, c'est-à-dire basée sur le traçage des documents source. …

Nouvelle donne dans le gaz naturel : GRDF s’adapte en utilisant l’IA

GRDF, leader de la distribution du gaz naturel en France, affine sa stratégie d’IA. Il s’appuie sur des serveurs internes pour la confidentialité des données de ses clients. GRDF c…

Et vous, qu’en pensez-vous ?

Une idée, une réaction, une question ? Laissez-nous un mot ci-dessous.

Je réagis à cet article