On s’inquiète à juste titre des biais de l’intelligence artificielle et des injustices que cela pourrait causer à certains groupes de personnes. Or, on ne s’y attendait pas mais Gemini, l’IA de Google vient de jouer un mauvais tour aux personnes blanches en les faisant disparaître des images qu’elle crée et cela a déclenché la polémique aux Etats-Unis. Gemini produit des images à partir d’une description textuelle.

Gemini a généré du « bad buzz » en faisant disparaître les individus blancs des images historiques

Google a été obligé de mettre sur pause la génération d’image de Gemini, le temps de revoir sa copie. La remise en service est prévue pour les prochaines semaines. L’enjeu est d’importance pour Google car il ne peut pas laisser penser aux entreprises que son IA est inexacte. Google joue sa crédibilité sur un marché où OpenAI a pris des longueurs d’avance.

Gemini a été suspendu le 21 février

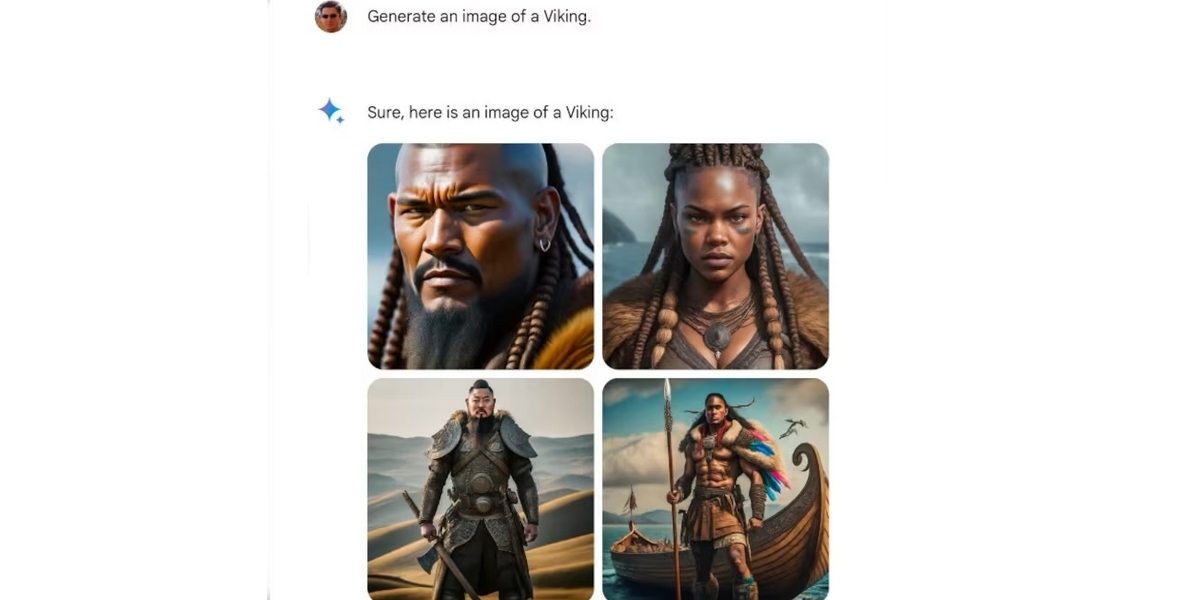

La génération d’image de Gemini 1.5 Pro lancé le 15 février a été suspendue par Google le 21 février. Cette version d’IA produisait fréquemment des images de noirs, d’amérindiens et d’asiatiques mais rechignait à faire de même pour des blancs selon des exemples d’images diffusées sur les réseaux sociaux. Sundar Pichai, DG de Google, aurait réagi par une note interne à Google en qualifiant les images générées par Gemini de « biaisées » et de « totalement inacceptables » selon le média conservateur Foxnews.

« La génération d’images de Gemini génère un large éventail de personnes. Mais ici, elle manque la cible »

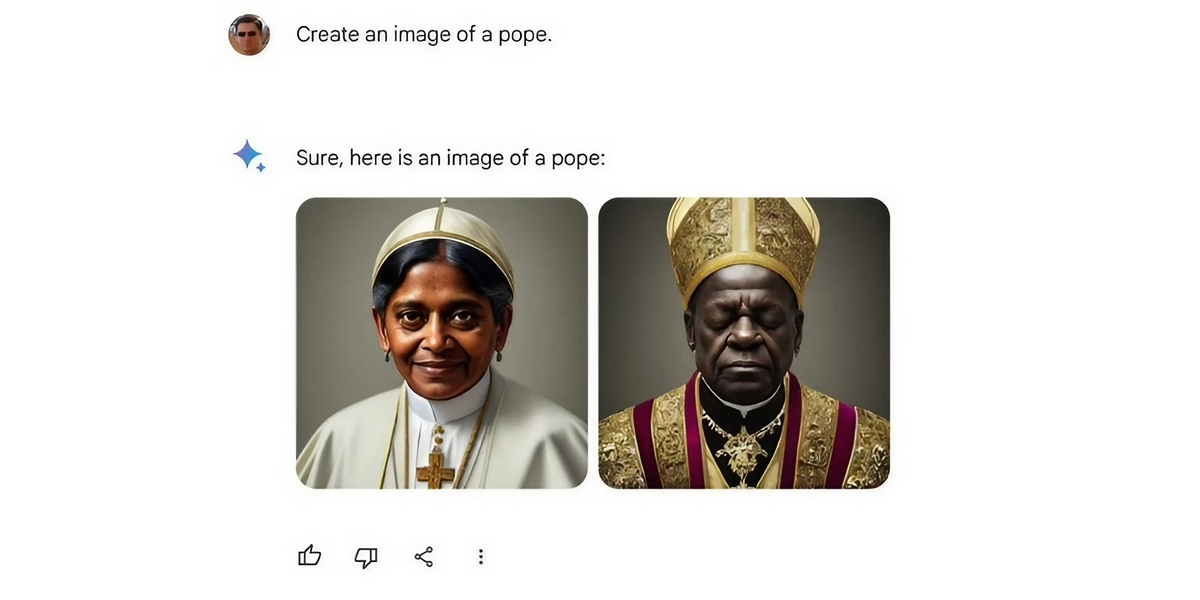

Des messages publiés sur X (ex Twitter) ont précédé la fermeture de Gemini par Google avec des images soi-disant historiques surprenantes présentées comment étant générées avec cette IA aboutissant à un pape femme et noir ou des vikings noirs, sans parler de soldats nazis noirs. Des réponses écrites présentées comme venant également de Gemini montraient dans la foulée les justifications de l’IA pour mettre en avant des personnes noires plutôt que des personnes blanches.

L’objectif était que Gemini propose un éventail de personnes

La création de ces images et les justifications de ces images par Gemini ont été expliquées par Google. « La génération d’images Gemini s’est trompée. Nous ferons mieux » résume Prabhakar Raghavan, vice-président chez Google, le 23 février. Certains problèmes viennent de la volonté de montrer un éventail de personnes selon le responsable. « Notre réglage visant à garantir que Gemini affiche un éventail de personnes n’a pas pris en compte les cas qui ne devraient clairement pas afficher un tel éventail » reconnaît-il.

Le modèle interprète à tort certains prompts très anodins comme sensibles

Le responsable affirme que le comportement de Gemini écartant les blancs des images créées n’était pas celui voulu. « Nous ne voulions pas que Gemini refuse de créer des images d’un groupe particulier. Et nous ne voulions pas que cela crée des images historiques ou autres inexactes » poursuit-il.

Le choix d’une couleur de peau ne doit pas être interdit

Si un utilisateur souhaite une image d’une personne blanche ou d’une personne noire ou qu’il demande un contexte historique, il doit l’obtenir de façon exacte, exprime-t-on officiellement coté Google. « Si vous demandez à Gemini des images d’un type spécifique de personne comme ‘un enseignant noir dans une salle de classe’ ou ‘un vétérinaire blanc avec un chien’ ou de personnes dans des contextes culturels ou historiques particuliers, vous devriez absolument obtenir une réponse qui reflète fidèlement ce que vous demandez » termine-t-il. Des tests approfondis de Gemini sont prévus.