Amazon Web Services (AWS) annonce la disponibilité de l’IA générative DeepSeek-R1 du chinois Deepseek sur le Cloud AWS.

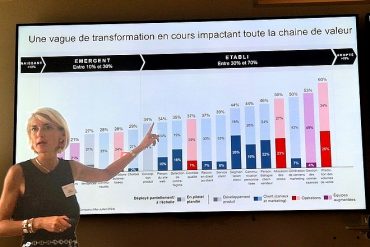

Aucun modèle n’est optimisé pour tous les cas d’usage

AWS souligne qu’il élargit continuellement son offre de modèles d’IA, incluant des modèles tels que DeepSeek-R1, en se basant sur les retours des clients. La raison en est qu’aucun modèle n’est optimisé pour tous les cas d’utilisation. Les clients doivent avoir accès à une variété de modèles afin de découvrir celui qui répond le mieux à leurs besoins. « A mesure que vous pouvez évoluer dans des applications d’IA générative, le coût du calcul compte vraiment. Les gens sont avides d’un meilleur rapport qualité-prix » retient AWS.

DeepSeek a bouleversé le marché des assistants conversationnels en annonçant des coûts de développement et des tarifs inférieurs à ceux d’OpenAI. AWS indique surveiller de près les besoins des clients et les avancées technologiques, et élargit régulièrement sa sélection de modèles pour inclure de nouveaux modèles prometteurs aux côtés des favoris établis de l’industrie. Le but est de proposer des modèles performants et différenciés et que ses clients restent à la pointe de l’innovation en matière d’IA.

Une sortie rapide de plusieurs modèles d’IA

Cela amène AWS à la startup chinoise d’IA DeepSeek. AWS rappelle que DeepSeek a lancé DeepSeek-V3 en décembre 2024, puis DeepSeek-R1, DeepSeek-R1-Zero avec 671 milliards de paramètres et les modèles DeepSeek-R1-Distill allant de 1,5 à 70 milliards de paramètres le 20 janvier 2025. Le 27 janvier 2025, ils ont ajouté leur modèle Janus-Pro-7B basé sur la vision.

Les modèles sont disponibles publiquement et seraient 90 à 95 % plus abordables et rentables que les modèles comparables. Selon Deepseek, leur modèle se distingue par ses capacités de raisonnement, obtenues grâce à des techniques d’entraînement innovantes telles que l’apprentissage par renforcement.

Différents modes de déploiement de DeepSeek-R1

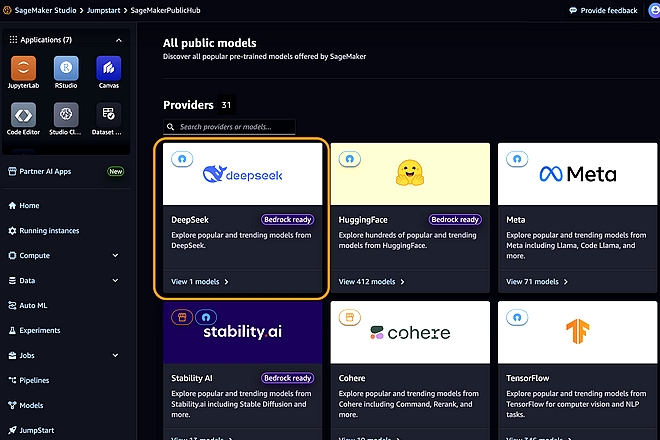

Il est maintenant possible de déployer les modèles DeepSeek-R1 de différentes façons : Amazon Bedrock Marketplace pour le modèle DeepSeek-R1 ; Amazon Bedrock Custom Model Import pour les modèles Llama distillés DeepSeek-R1 et Amazon SageMaker JumpStart pour le le modèle DeepSeek-R1.

On peut utiliser des instances Amazon EC2 Trn1 alimentées par les processeurs AWS Trainium pour les modèles distillés DeepSeek-R1.

La distillation est une technique de Machine Learning (Apprentissage automatique) qui consiste à transférer les connaissances d’un grand modèle d’IA pré-entraîné, le « modèle enseignant », à un « modèle élève » plus petit. Amazon SageMaker AI prend en charge l’exécution des modèles Llama et Qwen DeepSeek distillés. Les modèles DeepSeek peuvent être entraînés sur Amazon SageMaker AI au travers de l’intégration de Hugging Face.